Créer du contenu pour un site internet, qu'il soit sous forme d'informations prévues pour durer, ou bien au travers d'articles qui s'inscriront dans l'actualité, doit répondre à certains impératifs en termes de SEO et nous devons prêter de plus en plus attention à certains facteurs qui rentrent en ligne de compte dans le classement des résultats de recherche.

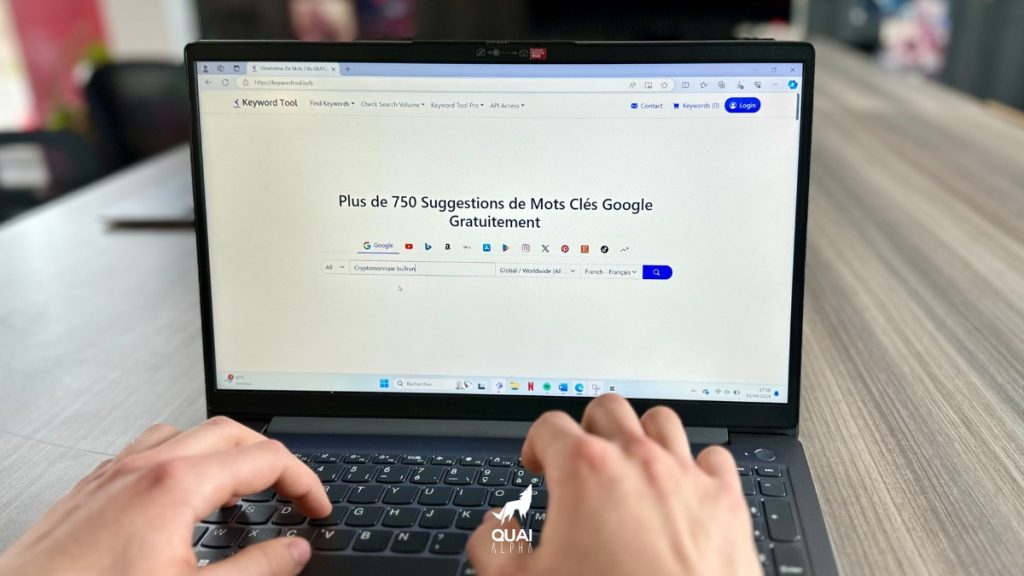

Lors de la création et de la mise en ligne de votre site web, vous allez devoir prendre en compte des aspects de la gestion de ce dernier tel que le référencement, plus communément abrégé en SEO (pour « Search Engine Optimization). En d’autres termes, cela consiste à rendre votre site le plus facilement et rapidement analysable par les différents moteurs de recherche (pour ne pas dire uniquement Google) pour que ce dernier puisse se retrouver en tête des recherches pour votre domaine 🔍

Mais pour bien comprendre comment cela fonctionne, il faut s’intéresser au mécanisme d’analyse des pages et du web tout entier par les algorithmes de Google, et notamment du sujet qui nous intéresse aujourd’hui : le Budget Crawl.

Voyons ensemble comment cela fonctionne.

👇

Pas le temps de tout lire ? Cliquez pour aller directement à la partie qui vous intéresse le plus :

→ Comprendre le concept de Budget Crawling

Qu'est-ce que le "Budget Crawling" ?

To crawl signifie « Ramper », ou encore « se faufiler ». Le Budget Crawling se réfère donc à la somme, au temps et aux ressources allouées par un tiers (dans ce cas précis Google) pour parcourir une page, des pages, et même le web dans sa quasi-totalité.

Habituellement représenté sous la forme d’une araignée parcourant sa toile (le web donc

Est-ce que cette dernière est bien façonnée et optimisée ? Et par conséquent, dois-je la mettre plus en avant dans le moteur de recherche ?

Rassurez-vous, cette approche et cette méthode d’analyse de pages ne vous concernera que si vous avez beaucoup de pages à faire parcourir (plus de 1 000 000 de pages individuelles ou plus de 10 000 mises à jours quotidiennement selon Google), mais la théorie reste néanmoins valable même à plus petite échelle, et ces informations vous serons sans doute utile quant à l’approche du SEO de votre propre site.

La mascotte de Google, « Googlebot », accompagnée ici d’un nouveau compagnon dévoilé en 2020, et dont l’apparence d’araignée fait référence au Crawling.

Ce terme désigne donc le temps que Google est prêt à vous allouer pour parcourir un site donné. Alors même que les ressources de cette méga-entreprise semblent illimitées, son temps lui, lui est précieux, et le web est vaste. Il doit donc prioriser et allouer un nombre déterminé de secondes passées sur chaque URL à analyser avant de passer au suivant.

Sa priorisation se base donc sur la popularité du site avec leurs utilisateurs, ainsi que la fraîcheur du contenu, car Googlebot semble avoir une préférence pour les URL neufs et qu’il n’a encore jamais parcouru.

Nous n’allons pas rentrer d’avantage dans les détails du fonctionnement de ce système; sachez juste que Googlebot, lors de sa visite, va être attentif au temps qu’il prend à parcourir votre site, et si tout est bien à sa place et facilement trouvable : plus rapide et facile sera son chemin, et plus votre site sera à même d’être recommandé lors d’une recherche (ndlr : Ce qu’on appelle plus généralement, et pour simplifier, l’algorithme PageRank)

Imaginez votre site comme une chambre : si tout est bien rangé et que l’espace est facilement praticable pour Googlebot, votre site sera mieux référencé que si tout traîne au sol et que rien se se trouve à sa place !

Quels sont donc les points clés du "Budget Crawl" ?

Si vous avez des problèmes à faire correctement indexer votre site (ndlr : « indexer son site » c’est le rendre parcourable par Google, et que ce dernier puisse détecter et référencer toutes les pages qui le composent, notamment grâce à un sitemap) ou bien que certaines pages enfouies plus profondément n’arrivent pas à être indexées, ou encore si vous trouvez que vos pages ne sont pas indexées assez rapidement, alors vous intéresser au « Budget Crawl » pourrait être une solution d’optimisation pour remédier à ces problèmes.

Nous allons donc voir ensemble non pas comment augmenter votre budget alloué à cette démarche, mais plutôt sur quels leviers jouer afin d’améliorer le crawling sur votre site.

L’un des problème pouvant être rencontré, est si votre site contient des pages qui ont la possibilité de générer de nouveaux URL : pensez par exemple à une page de recherche qui, en fonction de la recherche (interne au site) effectuée, génèrera à la volée un nouvel URL à chaque fois : difficile alors d’indexer tous ces URL potentiels.

Un autre problème pouvant être rencontré est si vous permettez à des utilisateurs de votre site de mettre en ligne du contenu sur ce dernier. Les éléments téléchargés seront alors tout autant de nouveaux URL créés et qui devront être eux aussi indexés, rendant cette dernière, ainsi que la traversée de Googlebot, plus longue et difficile.

Allégorie de Googlebot se frayant un chemin parmi les nouveaux URL générés de manière chaotique quotidiennement.

Comment corriger ces éventuels problèmes ?

Vous avez plusieurs options à votre disposition :

Liens normaux

Il s’agit là de la génération d’URL par défaut. De base, tous les liens de votre site seront parcourus, indexés, et passeront le PageRank. Si je passe par cet URL sur mon site et que Google suit ce dernier et indexe ces pages, alors ces pages seront en quelques sorte « recyclées » et tout restera dans cette « boucle d’indexation », limitant ainsi le risque qu’une page se perde en chemin.

Robots.txt

Maintenant à l’opposé total, la réponse la plus extrême que vous pourriez utiliser serait le fichier « robots.txt ». Si vous bloquez une page dans robots.txt, alors cette dernière ne pourra plus être crawled.

Formidable ! Problème réglé alors ?

En fait c’est plus compliqué que cela. Techniquement, les sites et pages bloquées dans robots.txt peuvent être indexées. Vous pourrez parfois voir apparaître dans une recherche des sites ou des pages sans description : c’est que ces derniers ont été bloqués par robots.txt.

Ces pages seront donc indexées, mais concrètement, elles ne seront pas classées de manière efficace dans la recherche, et elles ne passeront pas le PageRank. Cette solution n’est donc pas la réponse la plus « élégante », elle est néanmoins facile à mettre en place.

Liens "nofollow"

Si vous avez beaucoup de liens individuels tous très similaire, vous ne voulez pas forcément que Google fasse un listing de tous ces liens au cas par cas, on préférera alors indexer uniquement la page contenant ce listing, et c’est à cela que servira l’attribut « nofollow » (trouvable sous la forme rel=“nofollow”).

Cet attribut permettra de ne pas surcharger Googlebot lors de son parcours des différents liens, mais permettra néanmoins toujours à ces derniers d’êtres indexés et de passer le PageRank.

Noindex, Nofollow

Même principe que l’attribut ci-dessus, mais les liens ne seront cette fois pas indexés. Googlebot continuera alors à crawler ces différentes pages, mais constant les balises mises en place, il reviendra sur ces dernières bien moins souvent. Vous l’aurez compris, comme au dessus, cette méthode ne permet pas de passer le PageRank.

Noindex, Follow

Cette solution peut sembler paraître le meilleur des deux mondes : nous bénéficions toujours d’une certaine sorte de crawling de la part de Googlebot, et les pages ou liens superflus ne sont pas indexés, tandis que le « follow » nous permet de passer cette fois le PageRank.

Et bien il y a quelques années, Google est arrivé et a annoncé que, au vu du crawling étant de moins en moins récurrent sur ce genre de pages (en « noindex, follow »), les liens étaient de moins en moins vus et pris en compte par leur bot, et que cela venait remettre en cause le passage du PageRank, et finirai par être traité comme un « noindex, nofollow ».

Today, we’ve announced two new link attributes - “sponsored” and “ugc” - that join “nofollow” as ways to identify the nature of links. All will now work as hints about which links Google Search should consider or exclude for ranking purposes. More details:https://t.co/V6X2xjEC5L

— Google Search Central (@googlesearchc) September 10, 2019

En plus du « nofollow », Google a également mis en place de nouveaux attributs pour aider au référencements de liens sponsorisés, ou issus de contenu généré par les utilisateurs.

Canonique

Google nous dit : « Une URL canonique est l’URL de la page considérée par Google comme le plus représentatif de l’ensemble de pages dupliquées sur votre site. »

Mettre en place un attribut canonique permet donc de « classifier » les différentes URL dupliquées comme découlant d’un original, créant ainsi une sorte de « chaîne de liens » plus compréhensible par Googlebot que s’ils étaient indépendants les unes des autres, et que ce dernier devait retrouver de lui même l’original. En somme, les URL canoniques aident les moteurs de recherche à identifier les différentes variations d’une page et à les associer à un URL unique.

Cette méthode est similaire en terme de résultats au « noindex, follow », mais elle a pour avantage de n’avoir pas (ou peu) d’incidence sur le passage du PageRank au fil du temps.

Redirection 301

Faire une redirection 301 permet de modifier des URL et de proposer aux visiteurs le contenu attendu de manière transparente vis à vis de Google en lui communiquant le changement d’adresse de manière propre.

Cette méthode est encore meilleure que l’attribut canonique puisque Google n’aura même pas à regarder à l’intérieur de la page en question, puisque lors des rares occasions où il le fera, il n’aura qu’à suivre la règle de redirection 301.

Cela résoudra notre problème d’indexation et permettra également de passer le PageRank. Mais en échange, les utilisateurs ne pourront pas accéder à la page en question, mais uniquement à celle vers laquelle ils sont redirigé.

Que faut-il retenir de tout ça ?

Il n’existe pas une seule méthode miracle pour faire de notre site un espace de déambulation idéal pour l’araignée mécanique de Google. Il faut adapter le contenu de votre site et les URL qui le peuple de la manière qui vous semble la plus intéressante possible.

Également, il est important de noter que d’autres paramètres entre en ligne de compte, comme la vitesse de parcours de votre site, qui sera plus longue à mesure que votre site s’alourdira en contenu et scripts. C’est pourquoi il est important de veiller à avoir un temps de réponse rapide avec les serveurs, et une vitesse de chargement correcte des éléments.

Googlebot veut surtout des URL récents. Peut être que la meilleure solution resterai donc d’avoir un sitemap qui regroupe les URL les plus récents de votre site ? Cela pourrait être en tout cas une mesure facile à mettre en place.

Pour aller plus loin :

→ Budget crawl : comment l’optimiser ? chez Semrush

→ Guide sur la gestion du budget d’exploration pour les propriétaires de sites volumineux sur la documentation officielle de Google

→ How to optimize your crawl budget sur le blog de Yoast