Qu’est-ce que le Metaverse ? Découvrez le rôle de l’infrastructure réseau dans le Metaverse : bande passante, latence, fiabilité.

Voici la troisième partie de « Qu’est-ce que le Metaverse – le guide ultime pour tout comprendre », qui se concentre sur le rôle de l’infrastructure réseau dans le Metaverse. Le réseau est défini comme « la fourniture de connexions persistantes en temps réel, d’une bande passante élevée et d’une transmission de données décentralisée par les fournisseurs d’accès à internet, les réseaux, les centres d’échange et les services qui circulent entre eux, ainsi que ceux qui gèrent les données du « dernier kilomètre » vers les consommateurs ».

Les trois principaux domaines du réseau – la bande passante, la latence et la fiabilité – sont probablement les facteurs les moins intéressants pour les gens qui s’intéressent au Metaverse. Cependant, leurs contraintes et leur croissance déterminent la manière dont nous concevons les produits et services du Metaverse, le moment où nous pouvons les utiliser et ce que nous pouvons (et ne pourrons peut-être jamais) faire.

Pas le temps de tout lire ? Clique pour aller directement à la partie qui t’intéresse le plus :

→ Latence

Bande passante

La bande passante est communément assimilée à la » vitesse « , mais il s’agit en fait de la quantité de données pouvant être transmises par unité de temps. Les exigences du Metaverse sont bien plus élevées que celles de la plupart des applications et jeux Internet, et dépassent celles de la plupart des connexions modernes. La meilleure façon de comprendre cela est de se servir de Microsoft Flight Simulator.

Microsoft Flight Simulator est la simulation grand public la plus réaliste et la plus étendue de l’histoire. Il comprend 2 trillions d’arbres modélisés individuellement, 1,5 milliard de bâtiments et presque toutes les routes, montagnes, villes et aéroports du monde entier… qui ressemblent tous à la « réalité », car ils sont basés sur des scans de haute qualité de la réalité. Mais pour y parvenir, Microsoft Flight Simulator a besoin de plus de 2,5 pétaoctets de données, soit 2 500 000 gigaoctets. Il est impossible pour un appareil grand public (ou la plupart des appareils d’entreprise) de stocker une telle quantité de données.

Et même s’ils le pouvaient, Microsoft Flight Simulator est un service en direct qui se met à jour pour refléter les conditions météorologiques réelles (y compris la vitesse et la direction précises du vent, la température, l’humidité, le raid et l’éclairage) et le trafic aérien. Vous pouvez littéralement voler dans des ouragans et des tempêtes du monde réel, tout en suivant des avions de ligne IRL sur leur trajectoire exacte.

Above & around Hurricane Laura

— Petri Levälahti (@Berduu) August 27, 2020

Microsoft Flight Simulator (Live Weather) pic.twitter.com/T7v8aJ0jhG

Microsoft Flight Simulator fonctionne en stockant une quantité essentielle de données sur votre appareil local (qui exécute également le jeu, comme n’importe quel jeu sur console et contrairement aux services de streaming de jeux basés sur le cloud comme Stadia). Mais lorsque les utilisateurs sont en ligne, Microsoft diffuse d’immenses volumes de données sur l’appareil du joueur en local, en fonction des besoins. Pensez-y comme le ferait un pilote dans le monde réel. Lorsqu’il franchit une montagne ou prend un virage, de nouvelles informations lumineuses entrent dans sa rétine, révélant et clarifiant ce qui se trouve là pour la première fois. Avant cela, ils n’ont rien d’autre que la certitude que quelque chose sera là.

De nombreux joueurs pensent que c’est ce qui se passe dans tous les jeux vidéo multijoueurs en ligne. Mais, en réalité, la plupart des services de jeu n’envoient que des données de position, des données d’entrée du joueur (par exemple, tirer, lancer une bombe) et des données récapitulatives (par exemple, les joueurs restants dans une bataille royale) aux joueurs individuels.

Toutes les ressources et les données de rendu se trouvent déjà sur votre appareil local, d’où les temps de téléchargement et d’installation brutaux, ainsi que l’utilisation du disque dur.

Microsoft Flight Simulator réalise une nouvelle fois une prouesse technique en terme de réalisme

En envoyant les données de rendu au fur et à mesure des besoins, les jeux peuvent offrir une bien plus grande diversité d’objets, de ressources et d’environnements. Et ils peuvent le faire sans nécessiter de téléchargements et d’installations retardant le jeu, de mises à jour groupées ou d’énormes disques durs d’utilisateur. Par conséquent, de nombreux jeux adoptent désormais ce modèle hybride d’informations stockées localement et de flux de données.

Toutefois, cette approche est plus importante pour les plateformes axées sur le Metaverse. Roblox, par exemple, a besoin (et profite davantage) de la diversité des actifs, des objets et de l’environnement qu’un titre comme Mario Kart ou Call of Duty.

Au fur et à mesure que la complexité et l’importance de la simulation virtuelle augmentent, la quantité de données qui doit être diffusée augmentera. Pour l’instant, Roblox bénéficie du fait qu’un certain nombre de préfabriqués et de ressources sous-jacentes sont largement réutilisés et légèrement personnalisés. Dans ces conditions, Roblox diffuse principalement des données sur la façon de modifier les éléments téléchargés précédemment. Mais à terme, la plateforme virtuelle voudra un nombre quasi infini de permutations et de créations (qu’elle ne pourra presque jamais prévoir).

Les plates-formes de jumelage virtuel (également appelées « mondes miroirs »), telles que Microsoft Flight Simulator, doivent déjà recréer la diversité quasi infinie (et prouvable) du monde réel. Cela implique l’envoi de données beaucoup plus nombreuses (c’est-à-dire plus lourdes) que « nuage sombre ici » ou « un nuage sombre qui ressemble à 95 % au nuage sombre C-95 ». Il s’agit plutôt d’un nuage sombre exactement comme celui-ci. Et surtout, ces données changent en temps réel.

Ce dernier point est essentiel. Si nous voulons interagir dans un environnement virtuel vaste, en temps réel, partagé et persistant, nous devrons recevoir une surabondance de données transmises par le nuage.

Fortnite : Simple « Battle Royal » ou monde persistant en devenir ?

Comparez le « monde réel » à la carte de Fortnite. Tout le monde sur terre se trouve dans la même « simulation », au même moment, et avec une permanence totale. Si je coupe un arbre, cet arbre est irrévocablement parti et disparu pour tout le monde. Lorsque vous jouez à Fortnite, c’est uniquement via une version fixe et ponctuelle de la carte. Et tout ce que vous faites dans cette carte n’est partagé qu’avec une poignée d’utilisateurs, et pendant une courte période de temps avant d’être réinitialisé. Vous coupez un arbre ? Il sera réinitialisé dans un délai de 1 à 25 minutes, et il n’a jamais été partagé qu’avec 99 autres utilisateurs au départ. La carte ne change vraiment que lorsque Epic Games envoie une nouvelle version. Et si Epic Games voulait envoyer votre univers à tous les autres, il sélectionnerait votre univers, ne tiendrait pas compte du leur, et réparerait votre univers à un moment précis. Pour de nombreuses expériences virtuelles, c’est très bien. Ce sera également le cas pour de nombreuses expériences spécifiques au Metaverse. Mais certaines expériences (si ce n’est les plus importantes) voudront une persistance pour tous les utilisateurs, et à tout moment.

Le streaming de données dans le nuage est également essentiel si nous voulons passer de manière transparente d’un monde virtuel à l’autre. Le concert de Travis Scott dans Fortnite consistait à transporter les joueurs de la carte principale du jeu vers les profondeurs d’un océan jamais vu, puis vers une planète jamais vue, et enfin dans l’espace. Pour y parvenir, Epic a envoyé tous ces mondes de jeu aux utilisateurs quelques jours ou quelques heures avant l’événement par le biais d’un patch Fortnite standard (ce qui signifie, bien sûr, que si les utilisateurs n’avaient pas téléchargé et installé la mise à jour avant le début de l’événement, ils ne pourraient pas y participer). Ensuite, pendant chaque pièce de set, l’appareil de chaque joueur chargeait la pièce de set suivante en arrière-plan. Ce système fonctionne incroyablement bien, mais il exige que l’éditeur sache longtemps à l’avance dans quels mondes un utilisateur se rendra. Si vous voulez choisir, et choisir parmi un large éventail de destinations, vous devez soit télécharger l’intégralité de toutes les options potentielles (ce qui n’est pas possible), soit les diffuser en cloud stream.

Outre l’augmentation des données environnementales, il existe des données supplémentaires sur les joueurs. Lorsque vous voyez votre ami dans Fortnite aujourd’hui, le serveur Fortnite doit simplement vous envoyer des informations sur l’endroit où se trouve votre ami et sur ce qu’il essaie de faire ; les animations (par exemple, recharger un fusil d’assaut ou tomber) sont déjà chargées sur votre appareil et n’ont plus qu’à s’exécuter. Mais lorsqu’une capture de mouvement en temps réel est associée à l’avatar de votre ami, ces informations détaillées doivent également être envoyées. Comme tout le monde. Si vous voulez regarder un fichier vidéo au sein du jeu, comme le propose parfois Fortnite, il faut aussi le diffuser dans un monde virtuel. Entendre le son spatial d’une foule ? Pareil. Sentir un passant effleurer l’épaule de votre combinaison haptique ? Idem.

De nombreux joueurs se battent déjà avec la bande passante et la congestion du réseau pour les jeux en ligne qui ne nécessitent que des données de position et d’entrée. Le Metaverse ne fera qu’intensifier ces besoins. La bonne nouvelle est que la pénétration du haut débit et la bande passante s’améliorent constamment dans le monde entier. L’informatique, dont nous parlerons plus en détail dans la section 3, s’améliore également et peut aider à remplacer la transmission de données limitée en prédisant ce qui devrait se produire jusqu’au moment où les données « réelles » peuvent être remplacées.

Latence

Le plus grand défi des réseaux est aussi le moins bien compris : la latence. La latence est le temps que mettent les données pour aller d’un point à un autre et inversement. Comparée à la bande passante du réseau (ci-dessus) et à la fiabilité (ci-dessous), la latence est généralement considérée comme l’indicateur clé de performance le moins important. Cela s’explique par le fait que la plupart du trafic Internet est unidirectionnel ou asynchrone. Peu importe qu’il faille 100 ms, 200 ms ou même deux secondes entre l’envoi d’un message WhatsApp et la réception d’un accusé de réception. Peu importe également qu’il faille 20 ms, 150 ms ou 300 ms après avoir cliqué sur le bouton de pause de YouTube pour que la vidéo s’arrête. Lorsque vous regardez Netflix, il est plus important que le flux soit lu en continu que tout de suite. À cette fin, Netflix retarde artificiellement le début d’un flux vidéo pour que votre appareil puisse télécharger avant le moment même où vous regardez. Ainsi, si votre réseau se bloque pendant un moment ou deux, vous ne le remarquerez jamais.

Même les appels vidéo, qui sont des connexions synchrones et persistantes, ont une tolérance relativement élevée pour la latence. La vidéo étant l’élément le moins important des appels, les logiciels d’appel vidéo donnent généralement la priorité à l’audio, qui est la donnée la plus « légère », en cas de défaillance du réseau. Et si votre latence augmente temporairement – même de quelques secondes et non de quelques millisecondes – le logiciel peut vous sauver en augmentant la vitesse de lecture de votre backlog audio et en supprimant rapidement les pauses. En outre, il est facile pour les participants de gérer la latence – il suffit d’apprendre à attendre un peu.

Les jeux multijoueurs en ligne AAA les plus immersifs, cependant, exigent une faible latence. En effet, la latence détermine la vitesse à laquelle un joueur reçoit des informations (par exemple, où il se trouve, si une grenade a été lancée ou un ballon de football botté) et la vitesse à laquelle sa réponse est transmise aux autres joueurs. La latence, en d’autres termes, détermine si vous gagnez ou perdez, si vous tuez ou finissez par être tué. C’est pourquoi la plupart des jeux modernes se jouent à une fréquence d’images de 2 à 4 fois supérieure à la fréquence d’images moyenne de la vidéo et pourquoi nous avons rapidement adopté ces augmentations, même si nous résistons à une fréquence d’images plus élevée pour la vidéo traditionnelle. Les performances l’exigent.

Le seuil humain de latence est incroyablement bas dans les jeux vidéo, surtout par rapport aux autres médias. Prenons, par exemple, la vidéo traditionnelle par rapport aux jeux vidéo. Une personne moyenne ne remarque même pas que l’audio n’est pas synchronisé avec la vidéo, à moins qu’il n’arrive plus de 45 ms trop tôt ou plus de 125 ms trop tard (170 ms au total). Les seuils d’acceptabilité sont encore plus larges, à 90 ms en avance et 185 ms en retard (275 ms). Avec les boutons numériques, comme le bouton de pause de YouTube, nous ne pensons que nos clics ont échoué que si nous ne voyons pas de réponse après 200 à 250 ms. Dans les jeux AAA, les joueurs passionnés sont frustrés à 50 ms et même les non-joueurs se sentent gênés à 110 ms. Les jeux sont injouables à 150 ms. Subspace constate qu’en moyenne, une augmentation ou une diminution de 10 ms de la latence réduit ou augmente le temps de jeu hebdomadaire de 6 %. Il s’agit d’une exposition extraordinaire, à laquelle aucune autre entreprise n’est confrontée.

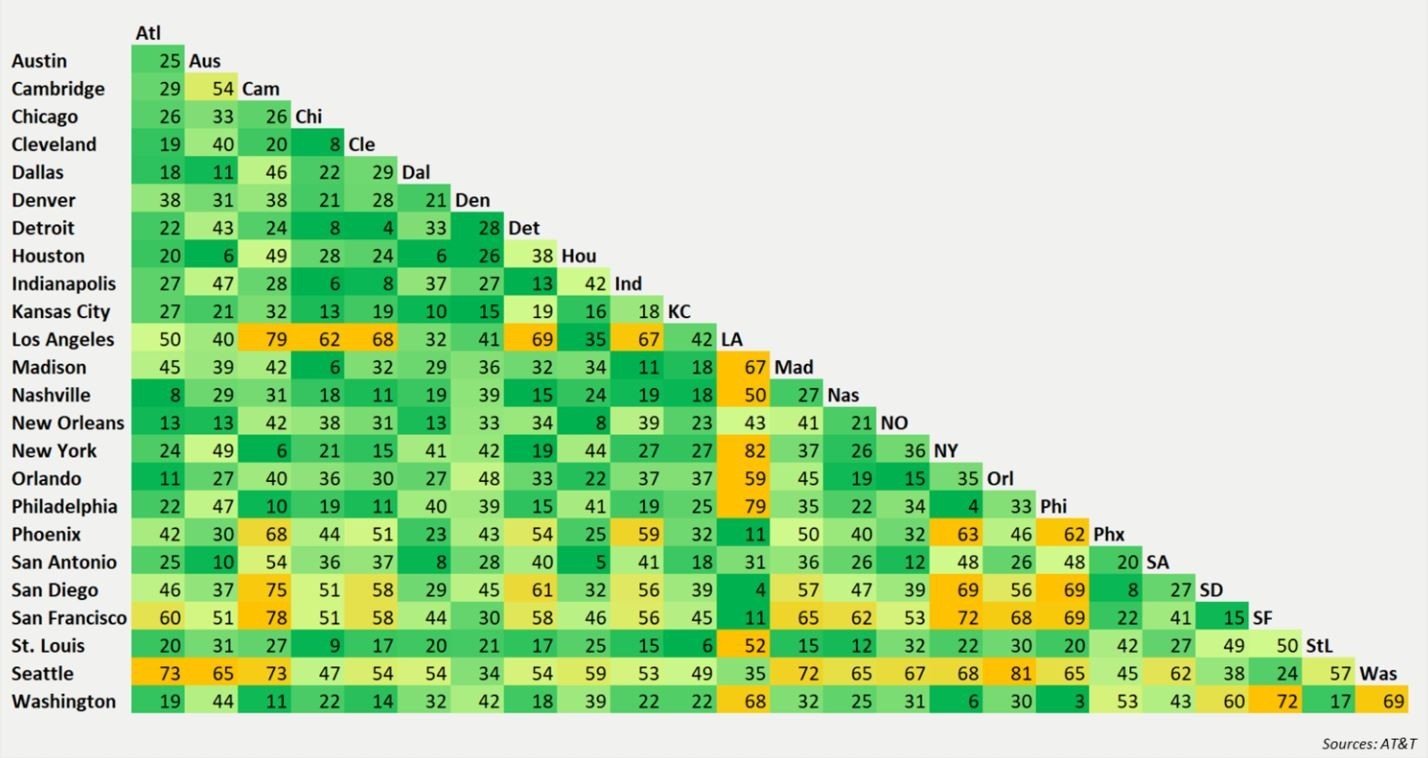

Tableau indiquant les temps de latence (en millisecondes) d’un serveur à une autre, entre différentes villes des États-Unis.

Avec les bandes ci-dessus à l’esprit, examinons la latence moyenne au niveau mondial. Aux États-Unis, le temps d’aller-retour médian pour les données envoyées d’une ville à une autre et inversement est de 35 ms. De nombreuses paires dépassent ce chiffre, notamment les villes à forte densité et à pics de demande intenses (par exemple, San Francisco vers New York en soirée).

Ensuite, il y a le temps de transit « de la ville à l’utilisateur », qui est particulièrement sujet à des ralentissements. Les villes denses, les quartiers ou les copropriétés peuvent facilement être congestionnés. Et si vous jouez via un téléphone portable, la technologie 4G actuelle offre une moyenne de 40 ms supplémentaires. Et si vous vivez en dehors d’un grand centre urbain, vos données peuvent avoir à parcourir une centaine de kilomètres supplémentaires sur une infrastructure filaire vétuste et mal entretenue. À l’échelle mondiale, la latence médiane de livraison varie de 100 à 200 ms entre les villes.

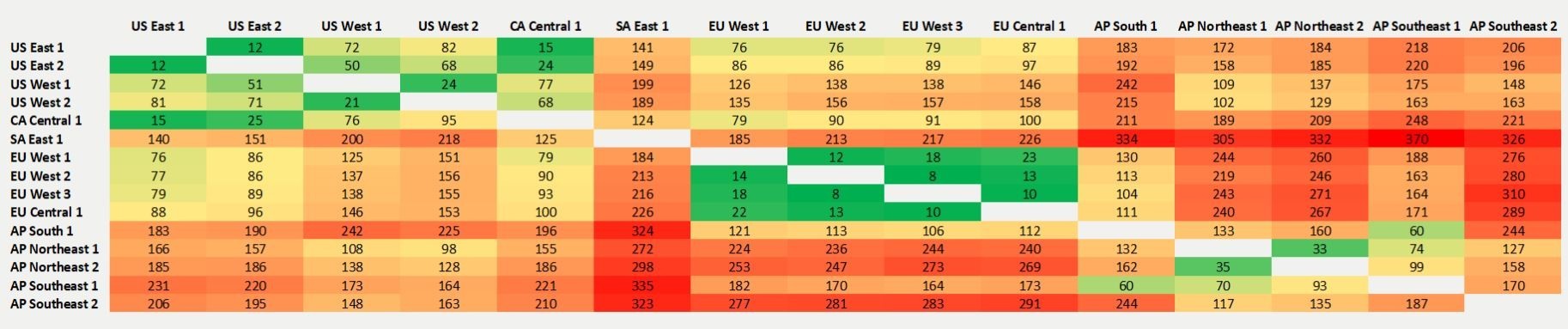

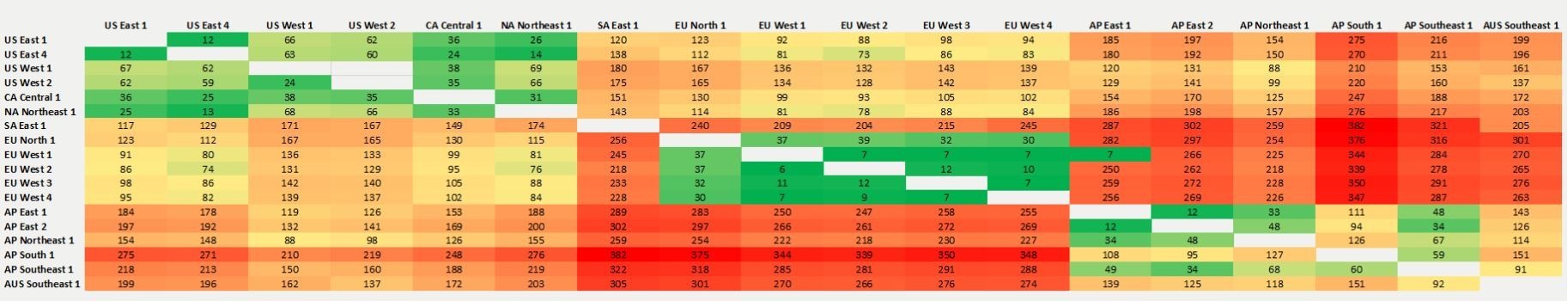

Tableau indiquant les temps de latence (en millisecondes) d’un serveur à un autre, entre différents continents.

Pour gérer la latence, l’industrie des jeux en ligne a mis au point un certain nombre de solutions partielles et d’astuces. Cependant, aucune n’est particulièrement efficace.

Par exemple, la plupart des jeux multijoueurs haute-fidélité sont conçus autour de régions de serveurs. En réduisant la liste des joueurs à ceux qui vivent dans le nord-est des États-Unis, en Europe occidentale ou en Asie du Sud-Est, les éditeurs de jeux sont en mesure de minimiser la latence sur une base géographique. Comme le jeu est une activité de loisir et qu’il se pratique généralement avec un ou trois amis, ce regroupement fonctionne assez bien. Après tout, il est peu probable que vous jouiez avec une personne située à plusieurs fuseaux horaires. Et vous ne vous souciez pas vraiment de savoir où vivent vos adversaires inconnus (auxquels vous ne pouvez généralement pas parler), de toute façon. Subspace constate néanmoins qu’environ trois quarts des connexions Internet au Moyen-Orient sont en dehors des niveaux de latence acceptables pour les jeux multijoueurs dynamiques, contre un quart aux États-Unis et en Europe. Cette situation reflète principalement les limites de l’infrastructure à large bande, et non l’emplacement des serveurs.

Les jeux multijoueurs en ligne utilisent également des solutions de « netcode » pour assurer la synchronisation et la cohérence et permettre aux joueurs de continuer à jouer. Le netcode basé sur le retard indique à l’appareil d’un joueur (par exemple, une PlayStation 5) de retarder artificiellement le rendu des entrées de son propriétaire jusqu’à ce que les entrées du joueur plus latent (c’est-à-dire de son adversaire) arrivent. Cela ennuie les joueurs dont la mémoire musculaire est adaptée à une faible latence, mais cela fonctionne. Le netcode Rollback est plus sophistiqué. Si les entrées de l’adversaire sont retardées, le dispositif du joueur procède en fonction de ce qu’il attendait. S’il s’avère que l’adversaire a fait quelque chose de différent, l’appareil essaiera de dérouler les animations en cours et de les rejouer « correctement ».

Ces solutions fonctionnent bien pour les jeux 1v1 (p. ex. les combats en 2D), pour les petits problèmes de latence (p. ex. ±40ms) et les titres comportant une gamme limitée d’actions hautement prévisibles (p. ex. un jeu de conduite, un combat en 2D). Mais à mesure que l’on passe à des expériences plus axées sur le Metaverse, avec un plus grand nombre de joueurs, de plus grandes variations de latence et des scénarios plus dynamiques, ces solutions se dégradent. Il est difficile de prévoir de manière cohérente et correcte une douzaine de joueurs, et de les faire revenir en arrière de manière non perturbatrice. Au lieu de cela, il est plus logique de déconnecter simplement un joueur qui présente un temps de latence. Et si un appel vidéo compte de nombreux participants, un seul compte réellement à la fois et il y a donc une latence « centrale ». Dans un jeu, obtenir les bonnes informations de tous les joueurs est important, et la latence s’y ajoute.

Une faible latence n’est pas un problème pour la plupart des jeux. Des titres tels que Hearthstone ou Words with Friends sont soit au tour par tour, soit asynchrones, tandis que d’autres jeux à succès tels que Honour of Kings ou Candy Crush ne nécessitent ni des entrées parfaites au pixel près ni des entrées précises à la milliseconde près. Ce ne sont vraiment que les titres à action rapide comme Fortnite, Call of Duty et Forza qui nécessitent une faible latence. Ces types de jeux sont lucratifs, mais ils ne représentent qu’une petite partie du marché total des jeux en termes de titres produits – et une part encore plus petite du temps de jeu total.

Même si le Metaverse n’est pas un jeu AAA à déclenchement rapide, sa nature sociale et l’importance qu’on lui accorde signifient qu’il nécessitera une faible latence. Les légers mouvements du visage sont extrêmement importants pour la conversation humaine, et nous sommes extrêmement sensibles aux petites erreurs et aux problèmes de synchronisation (d’où le problème de l’uncanny valley en CGI). Les produits sociaux, eux aussi, dépendent de leur omniprésence. Imaginez que FaceTime ou Facebook ne fonctionnent que si vos amis ou votre famille se trouvent à moins de 800 km, par exemple. Ou seulement lorsque vous êtes chez vous. Et si nous voulons exploiter le travail à l’étranger ou à distance dans le monde virtuel, il nous faut bien plus qu’une bande passante excessive.

Malheureusement, de tous les attributs du réseau, la latence est le plus difficile et le plus lent à corriger. Le problème vient en partie du fait que, comme nous l’avons mentionné plus haut, peu de services et d’applications ont besoin d’une diffusion à très faible latence. Cela limite l’analyse de rentabilité pour tout opérateur de réseau ou réseau de diffusion de contenu (CDN) axé sur la latence – et l’analyse de rentabilité est déjà remise en question et en conflit avec les lois fondamentales de la physique.

À 11 000-12 500 km, il faut 40-45 ms pour aller de New York à Tokyo ou Mumbai. Cela répond à tous les seuils de faible latence. Pourtant, alors que la plupart des dorsales de l’internet sont en fibre optique, la vitesse de la lumière est inférieure de 30 % à celle des câbles en fibre optique, car ceux-ci sont rarement dans le vide (+ la perte est généralement de 3,5 dB/km). Les câbles en cuivre et coaxiaux présentent une dégradation de la latence encore pire à distance, et une bande passante plus limitée, ce qui signifie de plus grands risques de congestion et de retard de livraison. Ces câbles représentent encore une grande partie de ceux que l’on trouve à l’intérieur des bâtiments résidentiels et commerciaux, ainsi que dans les quartiers.

En outre, aucun de ces câbles n’est posé à vol d’oiseau. Et ce que nous considérons généralement comme « l’épine dorsale de l’internet » est en réalité une fédération peu structurée de réseaux privés, dont aucun ne délivre entièrement un paquet de données (ou n’a intérêt à céder des tronçons à un concurrent disposant d’un ou deux segments plus rapides). Par conséquent, la distance de mise en réseau entre une paire de serveurs, ou entre un serveur et un client, peut être sensiblement plus grande que leur distance géographique. En outre, l’encombrement du réseau peut entraîner un acheminement encore moins direct du trafic afin de garantir une livraison fiable et continue, plutôt que de minimiser la latence. C’est pourquoi la latence moyenne entre New York et Tokyo est supérieure à 4 fois le temps que met la lumière à voyager entre les deux villes, et de 4 à 6 fois entre New York et Mumbai.

Il est incroyablement coûteux et difficile de mettre à niveau ou de relayer toute infrastructure câblée, surtout si l’objectif est de minimiser la distance géographique. Cela nécessite également une approbation réglementaire/gouvernementale considérable, généralement à plusieurs niveaux. Il est plus facile de réparer le sans-fil, bien sûr. Et la 5G y contribue certainement, puisqu’elle réduit la 4G de 20 à 40 ms en moyenne (et promet une latence aussi faible que 1 ms). Cependant, cela n’aide que les dernières centaines de mètres de transmission de données. Une fois que vos données ont atteint la tour, vous revenez aux dorsales traditionnelles.

Starlink, la constellation Internet par satellite de SpaceX, promet de fournir un service Internet à large bande passante et à faible latence à travers les États-Unis, et éventuellement le reste du monde. Mais cela ne résout pas le problème de la latence ultra-faible, en particulier sur de grandes distances. Si Starlink permet d’obtenir un temps de trajet de 18 à 35 ms entre votre domicile et le satellite et vice-versa, ce délai s’allonge lorsque les données doivent aller de New York à Los Angeles et vice-versa. Après tout, cela nécessite un relais entre plusieurs satellites. Dans certains cas, Starlink exacerbe même les distances de déplacement. La distance entre New York et Philadelphie est d’environ 100 miles en ligne droite et potentiellement de 125 miles par câble, mais de plus de 700 miles lorsqu’il s’agit d’aller vers un satellite en orbite basse et de redescendre.

En outre, le câble à fibres optiques est beaucoup moins sensible aux pertes que la lumière transmise dans l’atmosphère, notamment par temps nuageux. Les zones urbaines denses sont également bruyantes et donc sujettes à des interférences. En 2020, Elon Musk a souligné que Starlink est axé « sur les clients les plus difficiles à servir que les [entreprises de télécommunications] ont du mal à atteindre autrement. » En ce sens, il fait entrer davantage de personnes dans le Metaverse, plutôt que de stimuler celles qui y participent déjà.

Des technologies, des secteurs d’activité et des services entièrement nouveaux sont mis au point pour répondre au besoin croissant d’applications à bande passante en temps réel. Subspace (divulgation : société du portefeuille), par exemple, déploie du matériel dans des centaines de villes afin de développer des « cartes météorologiques » pour le cheminement des réseaux à faible latence, exploite une pile réseau qui coordonne ensuite les besoins d’une application à faible latence avec les nombreuses tierces parties qui constituent ce chemin, et a même construit un réseau optique qui se raccorde à divers réseaux à fibres optiques pour réduire encore la distance entre les serveurs et minimiser l’utilisation de câblage non fibreux.

Fastly, quant à lui, propose un CDN optimisé pour les applications à faible latence, plutôt que pour la fiabilité de la livraison et la bande passante. La société utilise une approche « infrastructure-as-code » qui permet aux clients de personnaliser presque tous les aspects de ses clusters de calcul en périphérie. Elle promet qu’une application logicielle peut effacer et remplacer tout le contenu mis en cache sur l’ensemble de ces clusters dans le monde entier en 150 ms, et qu’elle peut mettre en cache et accélérer les transactions individuelles de la blockchain en temps réel.

Fiabilité

La fiabilité est assez évidente. Notre capacité à passer au travail et à l’éducation virtuels dépend directement de la fiabilité de la qualité du service. Cela englobe à la fois le temps de fonctionnement global et la cohérence d’autres attributs tels que la largeur de bande de téléchargement et de chargement, et la latence. Pour beaucoup de ceux qui « vivent en ligne » aujourd’hui, une grande partie de ce qui précède peut sembler alarmiste. Netflix diffuse en 1080p ou même en 4K sans problème la plupart du temps ! Cependant, des services tels que Netflix exploitent des solutions de fiabilité qui ne fonctionnent pas bien pour les jeux ou les applications spécifiques au Metaverse.

Les services de vidéo en différé comme Netflix reçoivent tous les fichiers vidéo des heures, voire des mois, avant qu’ils ne soient mis à la disposition du public. Cela leur permet d’effectuer une analyse approfondie afin de réduire (ou « compresser ») la taille des fichiers en analysant les données des images pour déterminer quelles informations peuvent être supprimées. Les algorithmes de Netflix « regarderont » une scène avec un ciel bleu et décideront que, si le débit internet du spectateur diminue, les 500 nuances de bleu différentes peuvent être simplifiées à 200, ou 50, ou 25. Les analyses du diffuseur le font même sur une base contextuelle, en reconnaissant que les scènes de dialogue peuvent tolérer une plus grande compression que celles d’action rapide. C’est l’encodage multipasse.

Comme nous l’avons vu précédemment, Netflix utilise également la bande passante disponible pour envoyer la vidéo à l’appareil de l’utilisateur avant qu’elle ne soit nécessaire. Ainsi, en cas de baisse temporaire de la connectivité ou d’augmentation de la latence, l’utilisateur final ne subit aucun changement. En outre, Netflix précharge le contenu dans les nœuds locaux ; ainsi, lorsque vous demandez le dernier épisode de Stranger Things, il se trouve en fait à quelques rues de là. Cela n’est pas possible pour la vidéo ou les données créées en direct, qui, comme indiqué ci-dessus, doivent également arriver plus rapidement. C’est pourquoi il est plus difficile de diffuser en cloud-streaming 1 Go de Stadia que 1 Go de Netflix.

Ainsi, même si son objectif n’est pas nécessairement de nature compétitive, nous devrions considérer que le Metaverse élève les exigences de tous les aspects de la mise en réseau – latence, fiabilité/résilience et bande passante – au niveau de celles des jeux multijoueurs AAA. Peu importe la puissance de votre appareil (voir matériel et calcul) s’il ne peut pas recevoir toutes les informations dont il a besoin en temps voulu.